![Mein digitales Ich]()

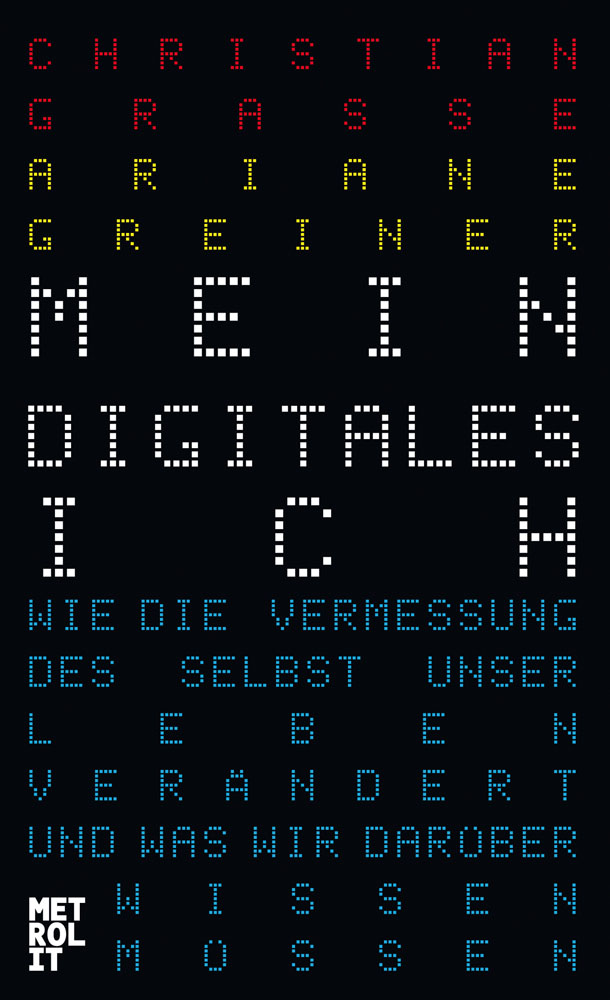

Mein digitales Ich

um die Jahrtausendwende mit etwa 128 Megabyte. Zum Vergleich: Der Computer, auf dem dieser Text entsteht, kann etwa viertausendmal so viele Daten speichern. Am 19. April 1965 machte ein Bericht des späteren Intel-Mitgründers Gordon Earle Moore die Entwicklung der Computertechnologie erstmals sichtbar. Sein Fazit: Die Leistung, Effizienz und Kapazität von elektronischen Rechenmaschinen verdoppelt sich alle zwei Jahre. Moores Gesetz des exponentiellen Rechenwachstums gilt bis heute. Trotzdem bleibt die Vorhersage zukünftiger Entwicklungen jenseits unserer Vorstellungskraft. Das verdeutlicht eine simple Analogie, die der italienische Autor und Aktivist Federico Pistono gerne in Vorträgen erklärt: Stellen Sie sich vor, Sie gehen 30 Schritte. Je nachdem, wo Sie dieses Buch gerade lesen, würden Ihre Füße Sie vielleicht in das Nachbarzimmer führen oder auf die gegenüberliegende Straßenseite. Es fällt Ihnen sicher nicht schwer, die Entfernung und die potenziell erreichbaren Orte einzuschätzen, da es sich bei den 30 Schritten um ein lineares Wachstum handelt und sich das Szenario innerhalb Ihres alltäglichen Erfahrungshorizontes bewegt. Wo aber würden Sie die 30 Schritte hinführen, wennSie sich nicht linear, sondern exponentiell fortbewegen würden? Also erst ein Schritt, dann zwei Schritte, vier, acht, sechszehn usw.? Haben Sie eine Vorstellung? Vielleicht die Straße entlang, zum Supermarkt und zurück oder sogar einmal rund um Ihren Wohnort? Nein, es wäre noch ein wenig mehr: Sie würden über 100 Milliarden Schritte gehen. Das heißt, Sie könnten nach Ihrem Einkauf im Supermarkt noch bequem zehnmal um die Erde wandern. Aber wozu diese Analogie? Sie soll verdeutlichen, welche unglaubliche Entwicklung die Computertechnik seit ihrer Anfangszeit vollzogen hat. Während die ersten Rechner es, metaphorisch gesehen, lediglich auf die gegenüberliegende Straßenseite schafften, bewegen sie sich heute in derselben Zeit zehnmal um die Erde. In zwei Jahren schaffen sie 20 Umrundungen, in vier 40, in sechs 80 usw. Keine Frage, in vielen Belangen sind Computer bereits heute übermenschlich und scheinbar uneinholbar weit entfernt vom Menschen. Lassen die Maschinen uns bald hinter sich zurück?

Die Domestizierung der wilden Rechenmaschine

Die ersten Computer basierten auf komplizierten und höchst anfälligen Lochkartensytemen. Jahrzehntelang füllten die Rechner ganze Etagen und benötigten ausgiebige Pflege und Wartung. Eines der Nebenprodukte ihrer Rechenleistung war Wärme, was optimale Bedingungen für Ungeziefer zur Folge hatte. Käfer, Motten und andere Insekten machten es sich in den riesigen Rechenmaschinen gemütlich und sorgten regelmäßig für Rechenfehler und Programmdefekte. Die Bezeichnung für die so entstandenen Fehler hat Bestand, denn unerwartete Vorgänge innerhalb einer Software werden bis heute »Bugs« genannt. Die digitalen Käfer haben also tatsächlich biologische Wurzeln. Mit der Zeit wurden die Anlagen trotz steigender Rechenleistung immer kleiner, was vor allem auf die stetig weiterentwickelte Elektro- und Transistortechnik zurückzuführen ist. Ihre Komplexität hatten die Computer jedoch nicht verloren, denn um sie steuern und mit Befehlen füttern zu können, musste man ihre Sprache lernen. Erst eine für normale Menschen unverständliche Folge von Zeichenketten hauchte den Maschinen Leben ein. Frühe Software musste im Maschinencode verfasst werden. Sogenannte höhere Programmiersprachen, die der menschlichen Sprache nachempfunden sind und nach Eingabe per Tastatur zwischen Programmierer und Maschine übersetzen, etablierten sich erst Jahre später. Dabei basierte die Kommunikation zwischen Mensch und Computer stets auf Textbasis – ein Trend, der bis in die Achtzigerjahre anhielt. Eine grafische Benutzeroberfläche, wie wir sie heute kennen, mit Fenstersystemen und visuellen Datei- und Ordnerstrukturen, wurde zwar bereits in den Siebzigerjahren konzeptuell erarbeitet, setzte sich aber erst 1984 mit dem ersten Apple Macintosh durch. Ein weiterer Meilenstein dieser ersten Apfel-Ära war die Computer-Maus. Auch dieses Bedienkonzept war zwar bereits seit Mitte der Sechzigerjahre bekannt, setzte sich jedoch erst mit dem Macintosh durch. Bis heute ist die Kombination aus Tastatur und Maus die vorherrschende Schnittstelle zum Rechner.

Die Entwicklung von grafischen Benutzeroberflächen, dieBedienung per Maus und das »natürliche« Schreiben per Tastatur könnte man als erste Phase der

Weitere Kostenlose Bücher